어제 포스팅 했는데, 뭔가 굉장히 찜찜한 마음이 들어서 추가적으로 공부를 해보고자 한다.

- https://www.whatwant.com/entry/HuggingFace-Learn-NLP

모델을 명시하지 않으면, "distilbert-base-uncased-finetuned-sst-2-english" 모델이 사용된다.

한글을 제대로 인식하지 못하는 모델이기에 다음과 같은 결과가 나온다.

이번에는 나름 유명한 koBert 모델로 지정해서 해보자.

이제는 조금 부정적인 것으로 인지하긴 하지만, 뭔가 부족하다.

한글을 잘 이해하는 모델을 어떻게 찾을 수 있을까?!

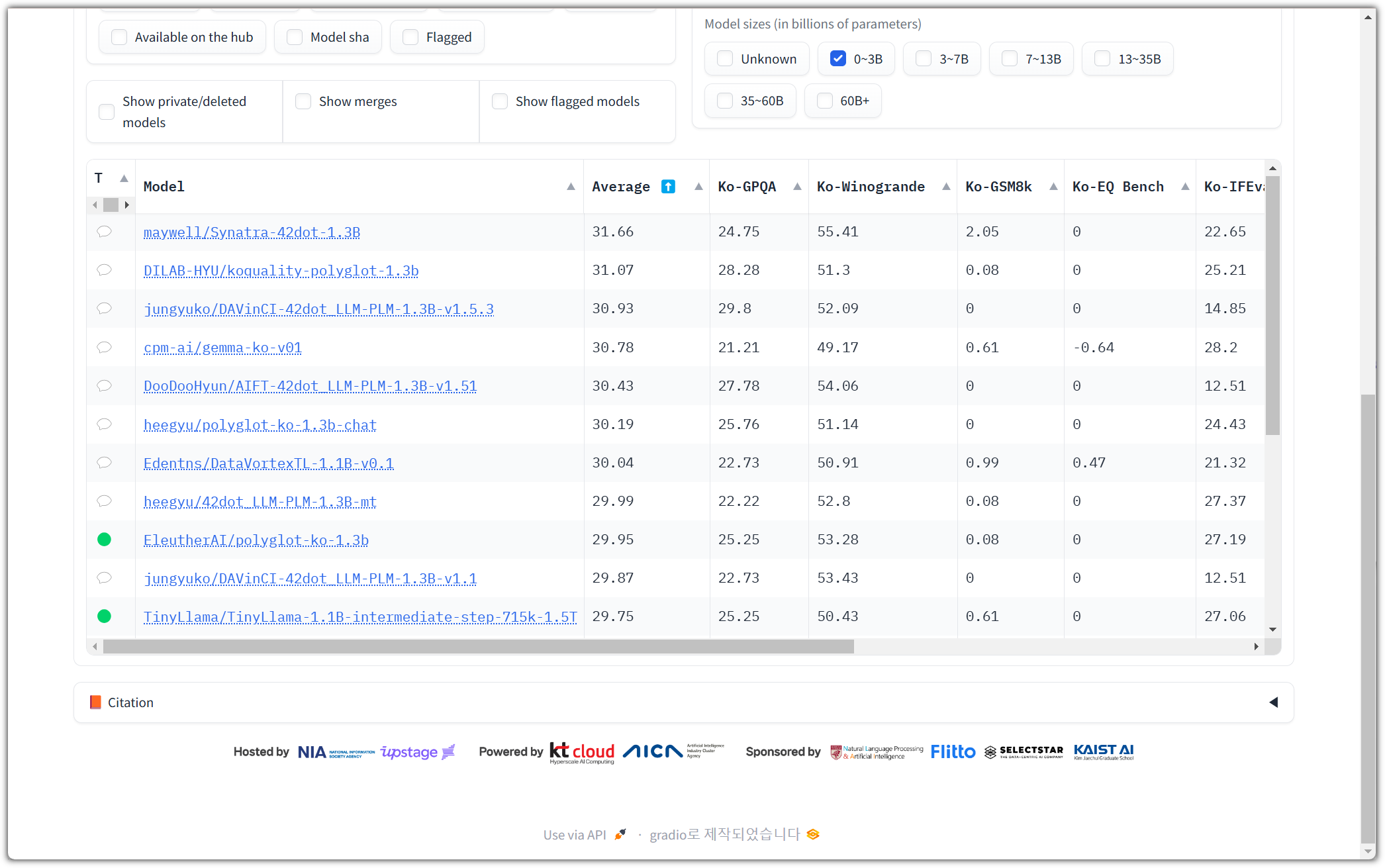

한글을 지원하는 LLM들의 성능 순위를 관리하는 곳 중에서 나름 유명한 곳이 있다.

- https://huggingface.co/spaces/upstage/open-ko-llm-leaderboard

Colab에서 실행하기 위해서는 Model Size는 좀 제한을 해야 한다.

내가 만약 A100이라던지 H100을 사용할 수 있다면 성능만 바라보고 할 수 있겠지만...

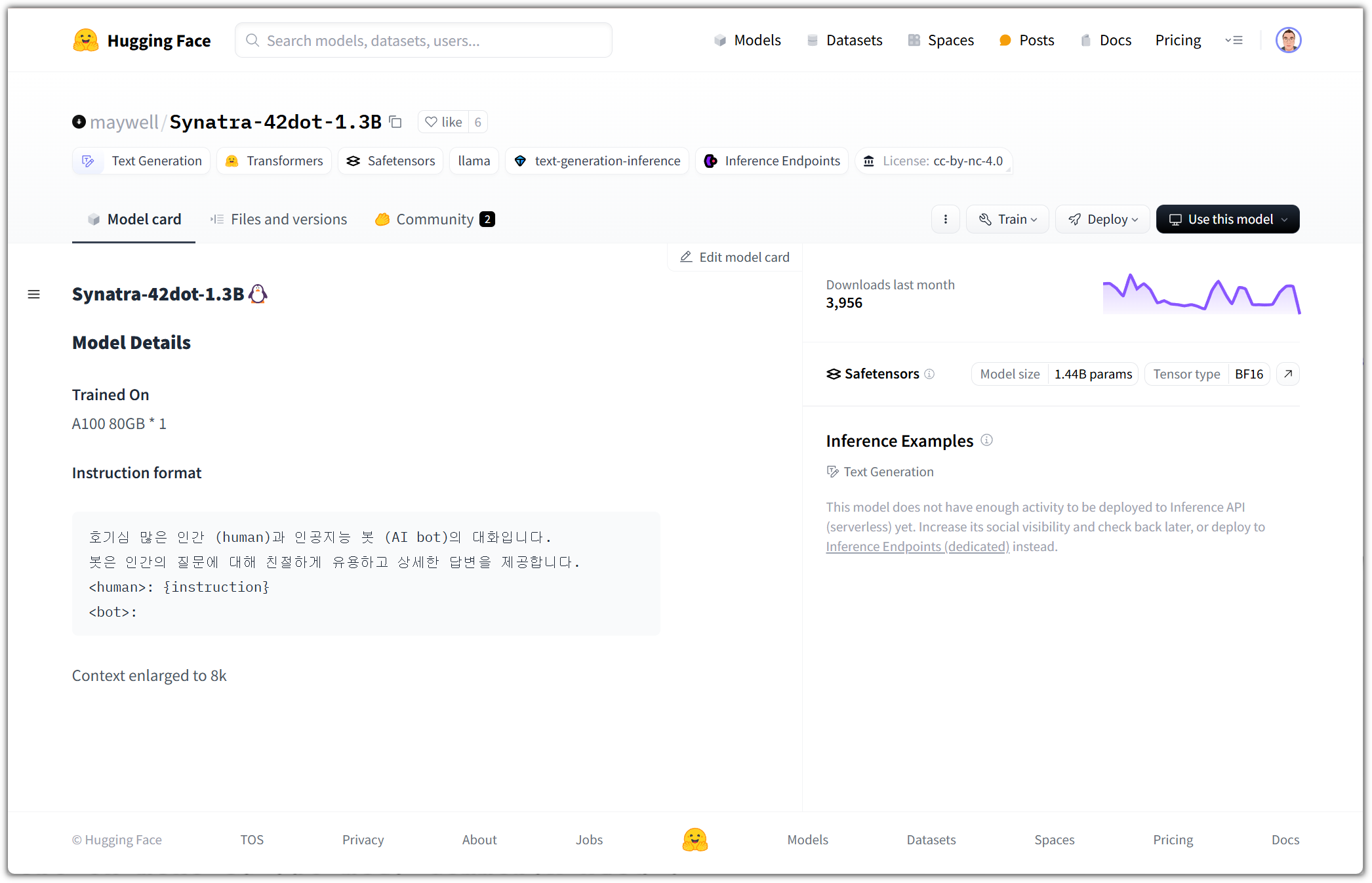

31.66점이라는 좀 많이 부족한 점수이지만 그래도 작은 사이즈의 모델에서는 어쩔 수 없다.

설명이 많이 부족하다.

사실 개인적으로 올리는 많은 모델들이 다 이렇다 ^^

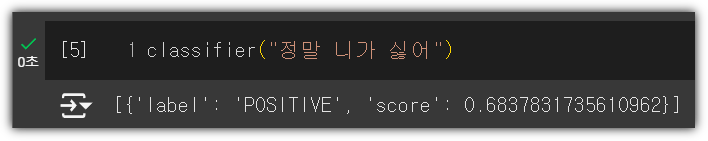

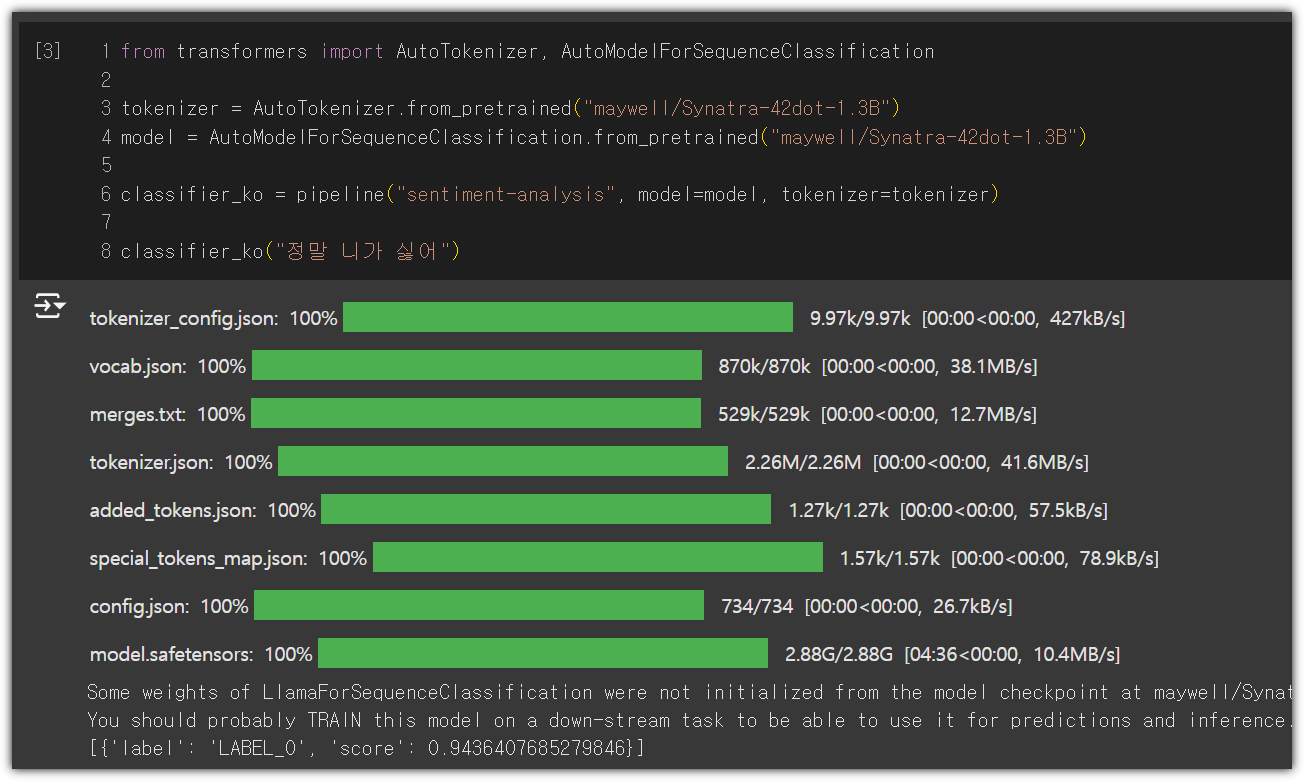

결과는 와우~!!!

LABEL_0 으로 0.94 score를 주고 있다. 부정적이라고 확신하는 것이다!!!

어제 포스팅에서 한글 모델을 사용했음에도 제대로 감정 분류를 하지 못하는 결과가 나와서 찜찜했는데,

그나마 짧은 시간 투자해서 원하는 수준 이상으로 결과가 나와서 뿌듯하다 ^^

이게 제대로 살펴본 것인지는 확신할 수 없지만, 나름 개인의 만족 !!!

'AI_ML > LLM' 카테고리의 다른 글

| HuggingFace - LLAMA 3.2 for Korean (0) | 2024.11.12 |

|---|---|

| HuggingFace - Learn - NLP Course #3 (2) | 2024.11.11 |

| HuggingFace - Learn - NLP Course (1) | 2024.11.09 |

| Gemini 잔소리꾼 만들기 (1) | 2024.11.08 |

| HuggingFace (허깅페이스 소개) (0) | 2024.06.24 |