이왕 살펴보는 김에 하나 더 해보려고 한다.

원하는 결과가 나오지 않을까봐 살짝 무섭기도 한데.... ^^

뉴스 제목을 보고 어떤 카테고리인지 맞춰보는 것을 한 번 해보려고 한다.

네이버 뉴스 데이터를 이용해보자.

정치, 경제, 사회 등의 카테고리 별로 현재 상단에 있는 뉴스 제목들을 가지고 와봤다.

|

from transformers import pipeline

classifier = pipeline("zero-shot-classification")

labels = ["정치", "경제", "사회", "생활/문화", "IT/과학", "세계"]

articles = [

"尹 대통령 선물받은 투르크 국견 해피·조이, 관저 떠나 서울대공원으로",

"트럼프, 인플레 우려에 관세폭탄 못할것",

"똑바로 살겠다…반성문 3번 쓴 음주뺑소니 김호중, 검찰은 징역 3년6개월",

"천재화가 천경자 특별전 개막..미공개 작품도 선 보여",

"매출 25% AI투자, 초개인화 'AI 검색' 일상속으로",

"네타냐후, 트럼프 당선에 ‘폭주’…팔·레바논 등 공격 100명 사망"

]

classifier(articles, candidate_labels=labels)

|

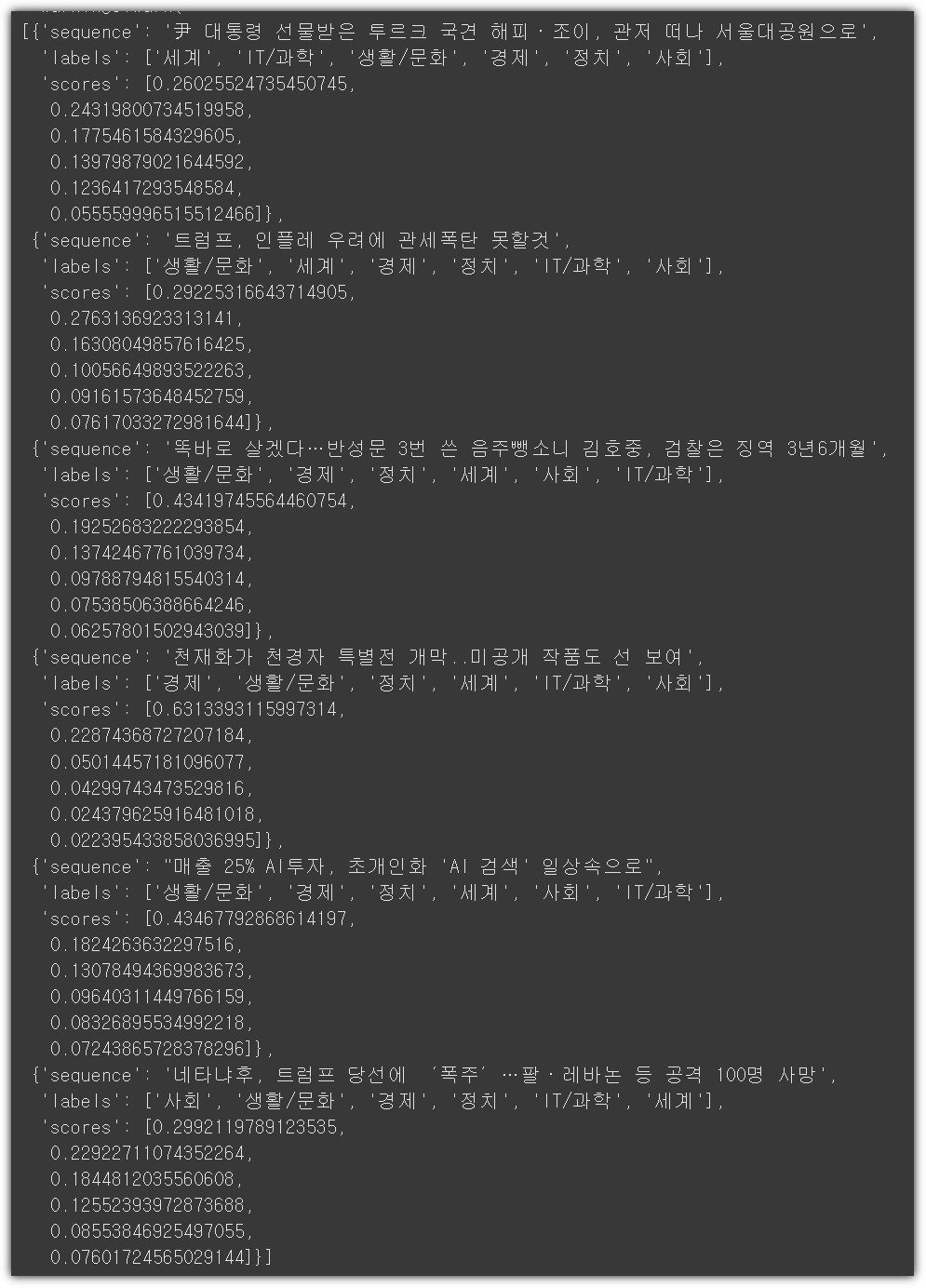

실행결과는 다음과 같이 나온다.

정답률이 엄청 안좋기 때문에 ^^

Top3 포함되면 정답으로 계산해서 33점.

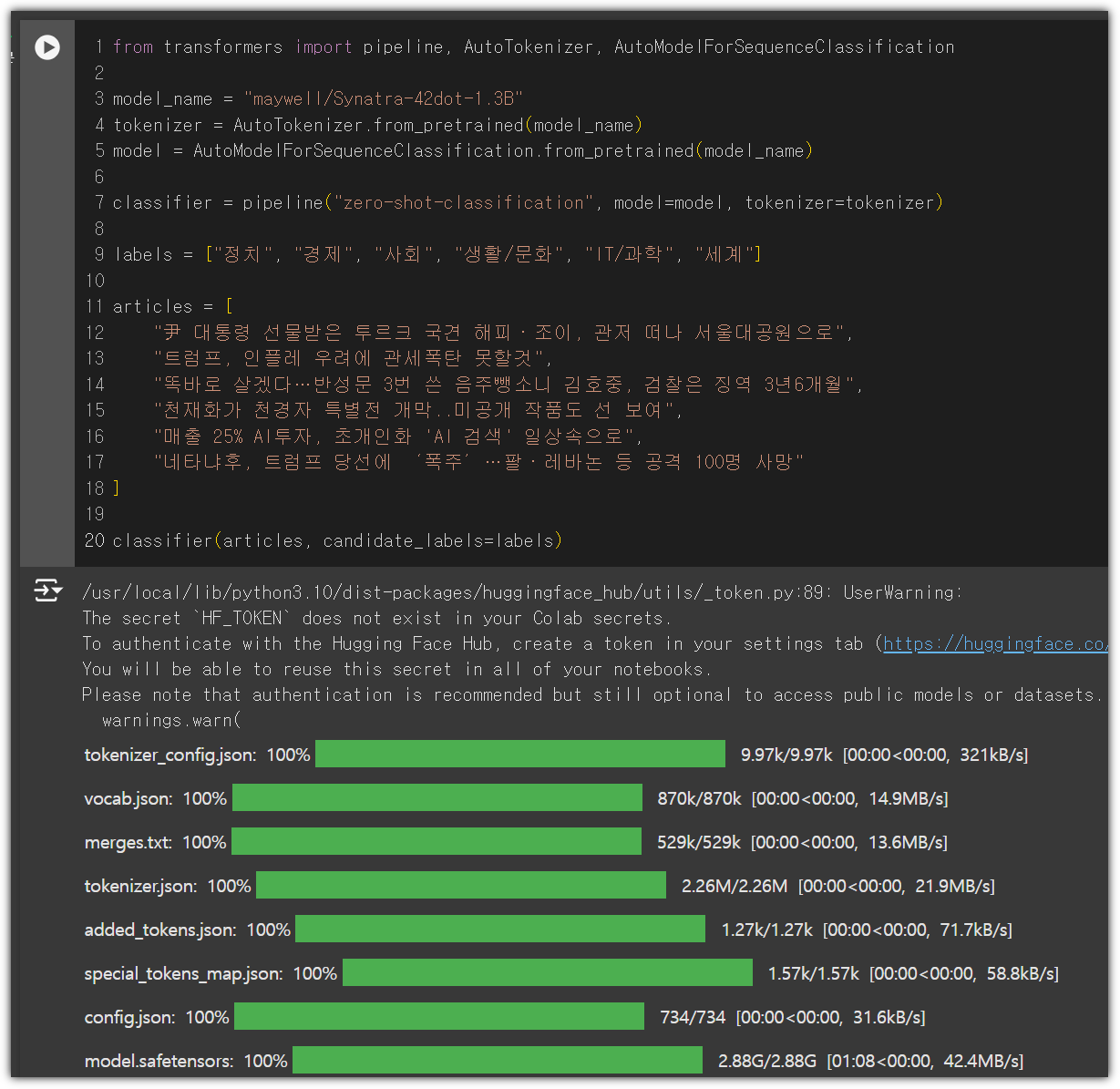

이번에는 ko-LLM 리더보드에서 현재 1위를 하고 있는 모델을 이용해봤다.

|

from transformers import pipeline, AutoTokenizer, AutoModelForSequenceClassification

model_name = "maywell/Synatra-42dot-1.3B"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForSequenceClassification.from_pretrained(model_name)

classifier = pipeline("zero-shot-classification", model=model, tokenizer=tokenizer)

labels = ["정치", "경제", "사회", "생활/문화", "IT/과학", "세계"]

articles = [

"尹 대통령 선물받은 투르크 국견 해피·조이, 관저 떠나 서울대공원으로",

"트럼프, 인플레 우려에 관세폭탄 못할것",

"똑바로 살겠다…반성문 3번 쓴 음주뺑소니 김호중, 검찰은 징역 3년6개월",

"천재화가 천경자 특별전 개막..미공개 작품도 선 보여",

"매출 25% AI투자, 초개인화 'AI 검색' 일상속으로",

"네타냐후, 트럼프 당선에 ‘폭주’…팔·레바논 등 공격 100명 사망"

]

classifier(articles, candidate_labels=labels)

|

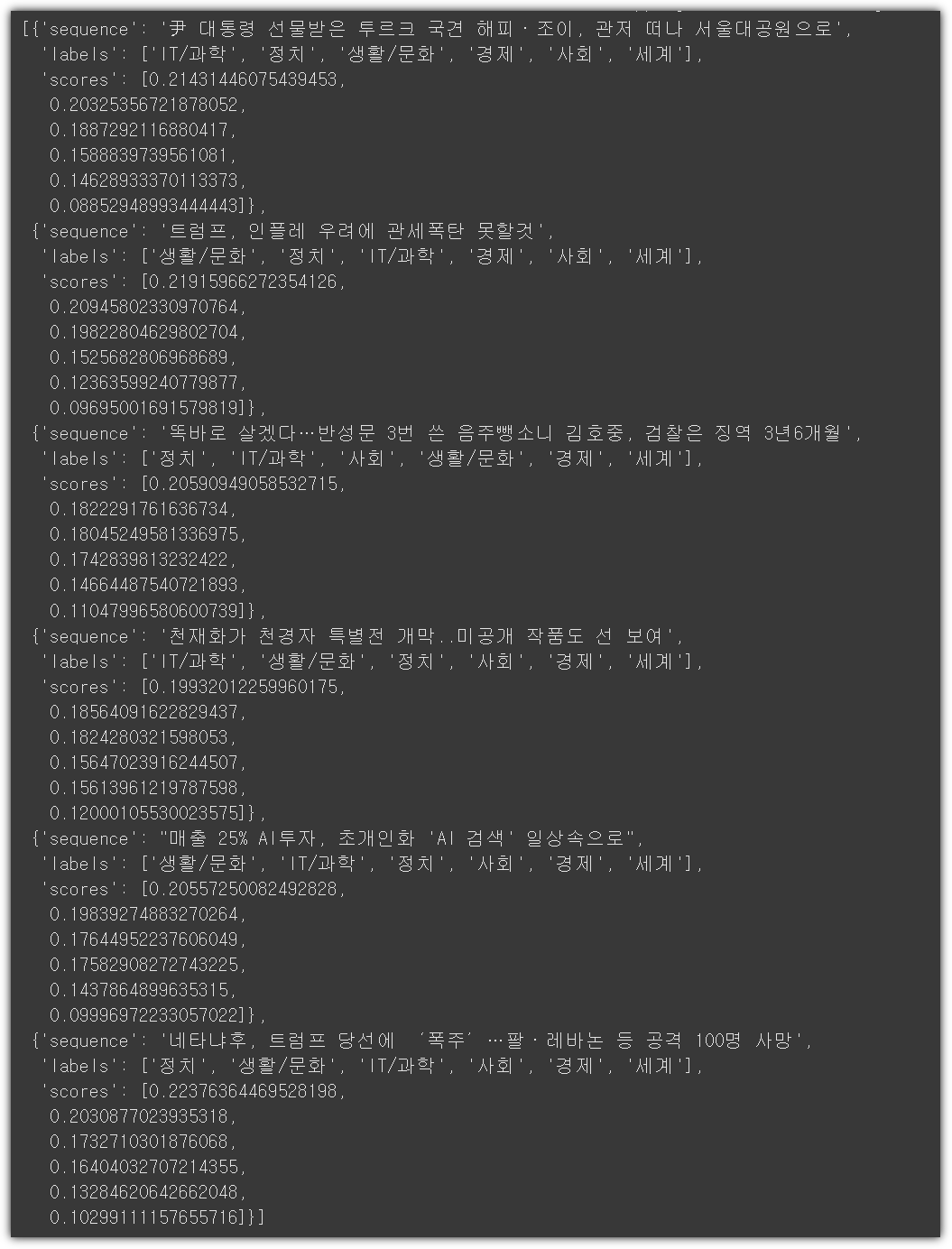

실행결과는 다음과 같다.

마찬가지로 Top3에 포함된 것 기준으로 67점이다.

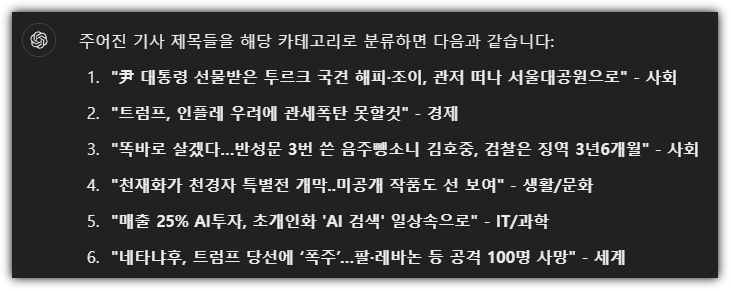

혹시나 하고 ChatGPT를 시켜봤더니 Top1으로 해서 1개 빼고 모두 잘 분류했다. 역시 ChatGPT !!!

위의 작은 모델들은 Top1으로 하면 처참한 결과인데...

뭐 결과는 조금 마음에 들지는 않지만,

그래도 머리속에 있는 아이템을 가지고 HuggingFace를 이용해서 어떻게 해야할지에 대해서는

간단히 잘 살펴본 것 같다. (ChatGPT의 위대함을 느낀 것이 더 큰가?)

반응형

'AI_ML > LLM' 카테고리의 다른 글

| HuggingFace - LLAMA 3.2 for Korean (0) | 2024.11.12 |

|---|---|

| HuggingFace - Learn - NLP Course #2 (0) | 2024.11.10 |

| HuggingFace - Learn - NLP Course (1) | 2024.11.09 |

| Gemini 잔소리꾼 만들기 (1) | 2024.11.08 |

| HuggingFace (허깅페이스 소개) (0) | 2024.06.24 |